En el fascinante mundo de la Inteligencia Artificial, los Grandes Modelos de Lenguaje (LLMs) han demostrado capacidades asombrosas. Sin embargo, no están exentos de desafíos, como la tendencia a «alucinar», su conocimiento limitado hasta la fecha de su entrenamiento y la dificultad para realizar razonamientos complejos o interactuar con el mundo exterior. Aquí es donde entran en juego los agentes ReAct (Reasoning and Acting) y LangGraph, una poderosa biblioteca que simplifica su construcción.

Esta guía para principiantes te sumergirá en el corazón de cómo combinar estas dos innovaciones para crear agentes de IA más robustos, capaces de razonar, actuar y aprender de sus observaciones.

¿Qué son los Agentes ReAct?

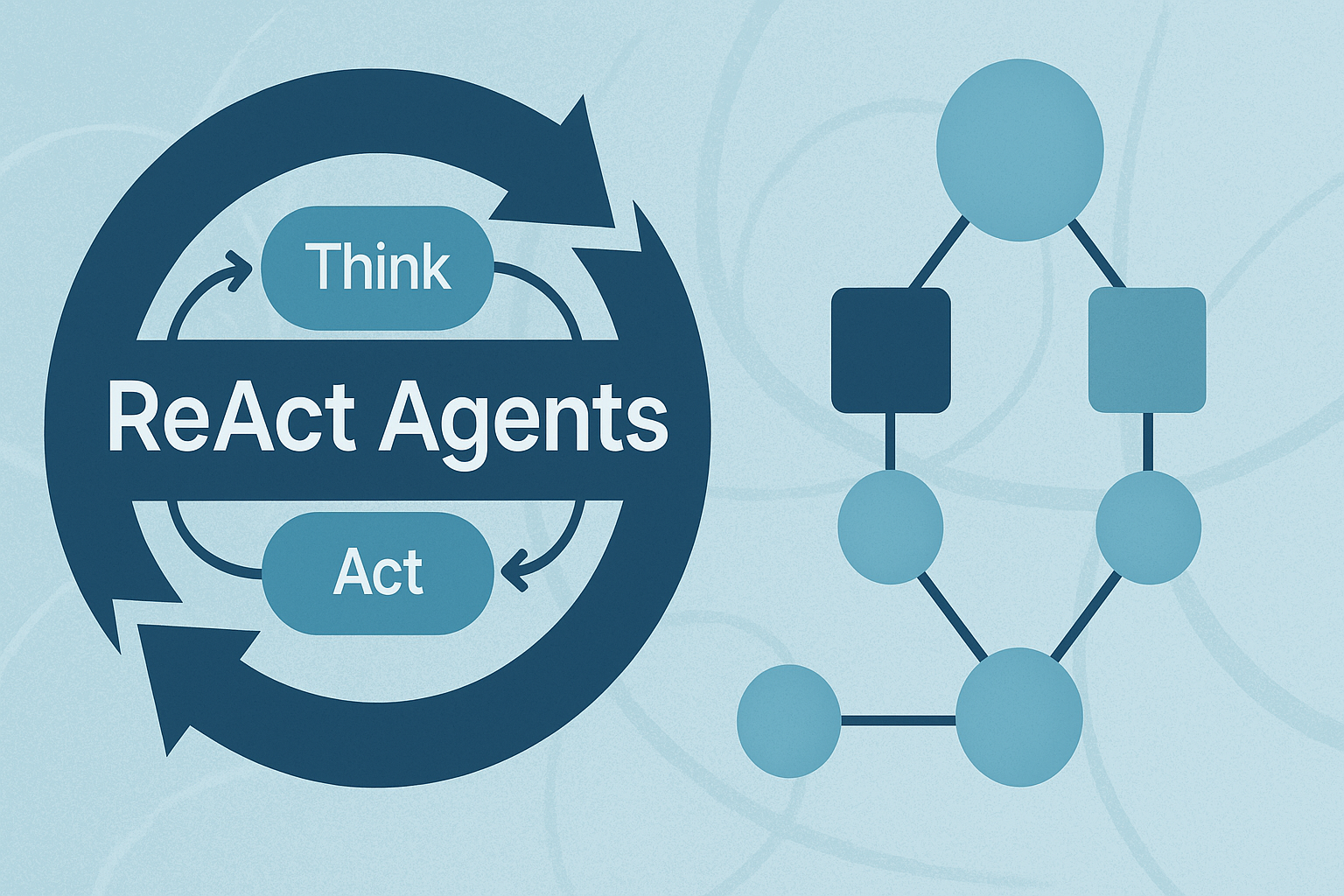

El paradigma ReAct propone una solución elegante a las limitaciones de los LLMs puros al fusionar dos componentes esenciales: el razonamiento y la acción. Un agente ReAct opera en un ciclo iterativo, emulando el proceso de pensamiento humano para resolver problemas:

- Pensamiento (Reasoning): El LLM genera un monólogo interno, articulando su plan, evaluando la situación actual o reformulando el problema. Esto le permite planificar estratégicamente y justificar sus decisiones.

- Acción (Acting): Basándose en su pensamiento, el LLM selecciona y utiliza una herramienta externa. Estas herramientas pueden ser cualquier cosa: un motor de búsqueda web, una calculadora, una base de datos, una API personalizada, un intérprete de código Python, etc.

- Observación (Observation): El resultado de la acción de la herramienta se devuelve al LLM. Esta observación se convierte en una nueva pieza de información que el agente utiliza para su siguiente ciclo de pensamiento y acción.

Este ciclo de Pensamiento → Acción → Observación se repite hasta que el agente logra una solución final o completa su tarea. Los beneficios son claros: mayor precisión, reducción de alucinaciones, la capacidad de acceder a información en tiempo real y la habilidad de interactuar dinámicamente con entornos complejos, transformando los LLMs de meros generadores de texto en entidades capaces de verdadera interacción y resolución de problemas.

¿Por qué LangGraph para Agentes ReAct?

Mientras que LangChain proporciona las herramientas y cadenas para construir componentes de LLMs, LangGraph lleva la orquestación a un nivel superior. Está diseñado específicamente para construir aplicaciones multi-actor con LLMs que requieren gestión de estado y ciclos de ejecución. Esto lo hace el compañero perfecto para los agentes ReAct:

- Grafos con Estado (Stateful Graphs): LangGraph permite definir máquinas de estado complejas donde cada nodo del grafo puede ser una llamada al LLM, la invocación de una herramienta o una función personalizada. El estado (contexto de la conversación, resultados intermedios) se pasa y se actualiza entre los nodos, algo fundamental para el proceso iterativo de ReAct.

- Ciclos y Bucles Nativos: La naturaleza repetitiva del ciclo ReAct (pensar, actuar, observar) se adapta perfectamente a la capacidad de LangGraph para definir ciclos de ejecución dentro del grafo. Esto permite a los agentes ejecutar repetidamente pasos hasta que se cumpla una condición específica (por ejemplo, obtener una respuesta final).

- Modularidad y Flexibilidad: Permite descomponer comportamientos complejos del agente en nodos más pequeños y manejables. Esto mejora la legibilidad, el mantenimiento y la reutilización del código, facilitando la construcción de agentes escalables.

- Visibilidad y Depuración: Al visualizar el flujo del agente como un grafo, es mucho más fácil entender cómo se toman las decisiones y dónde pueden surgir problemas, facilitando enormemente la depuración y optimización del comportamiento del agente.

- Soporte para Agentes Múltiples: Aunque nos centramos en un solo agente ReAct, LangGraph puede escalar para orquestar sistemas multi-agente donde varios agentes ReAct colaboran para resolver problemas más grandes, asignando roles y coordinando sus acciones.

Conceptos Clave de LangGraph para ReAct

Para construir un agente ReAct con LangGraph, es crucial entender estos elementos fundamentales:

- El Grafo (Graph): La estructura fundamental que define la secuencia de ejecución. Se compone de nodos y aristas (edges). Piensa en él como un diagrama de flujo donde los pasos y las decisiones están claramente definidos.

- Nodos (Nodes): Representan los pasos discretos en la ejecución del agente. Cada nodo ejecuta una función o un modelo de lenguaje.

- Nodo LLM: Donde el LLM genera el pensamiento y decide la próxima acción (o respuesta final). Aquí es donde la inteligencia del modelo se aplica para procesar la información y planificar.

- Nodo de Herramienta: Donde se ejecuta una herramienta externa (como una búsqueda web o una API). Este nodo interactúa con el mundo exterior al agente.

- Nodos Personalizados: Para lógica de pre-procesamiento, post-procesamiento o condicional. Permiten adaptar el flujo del agente a necesidades específicas.

- Aristas (Edges): Definen el flujo o las transiciones entre nodos. Indican qué nodo se ejecutará después de otro.

- Aristas Condicionales: Son esenciales para ReAct. Basándose en la salida de un nodo (por ejemplo, si el LLM decide usar una herramienta o dar una respuesta final), la ejecución se dirige a un nodo diferente. Esto permite una toma de decisiones dinámica.

- Estado (State): La información que persiste y evoluciona a lo largo de la ejecución del grafo. Para ReAct, el estado suele incluir el historial de mensajes (conversación), los pensamientos y acciones intermedias, y los resultados de las herramientas. LangGraph ofrece la clase

AgentStatepara gestionar esto de forma efectiva, permitiendo definir un esquema claro para la información que se lleva a través del grafo y asegurando que el agente mantenga el contexto relevante en cada paso.

Construyendo un Agente ReAct Básico con LangGraph (Pasos Conceptuales)

Aunque el código específico requeriría un tutorial paso a paso, los pasos conceptuales para construir un agente ReAct funcional son los siguientes:

- Definir el Estado del Agente: Crear una clase que herede de

TypedDict(o similar) para especificar qué información se mantendrá y pasará a través del grafo. Esto incluiría una lista de mensajes (HumanMessage,AIMessage,ToolMessage) para el historial de conversación y una lista de pasos intermedios (AgentAction,ToolMessage) para rastrear el bucle ReAct. - Definir Herramientas: Crear o importar las herramientas que el agente utilizará. Por ejemplo, una herramienta de búsqueda web (como

TavilySearchResultspara acceso a internet), un intérprete de código Python (PythonREPLToolpara lógica o cálculos) o cualquier API personalizada para interactuar con sistemas específicos. Se suelen envolver con el decorador@toolde LangChain para hacerlas invocables por el LLM. - Configurar el LLM: Instanciar un LLM potente y capaz de invocar herramientas (funcionalidad de «función de llamada» o «tool calling»). Modelos como GPT-4 de OpenAI, Claude 3 de Anthropic o modelos de código abierto afinados son excelentes opciones por su capacidad de razonamiento y comprensión de herramientas.

- Crear Nodos del Grafo:

- Nodo

call_llm: Este nodo es responsable de enviar los mensajes actuales del estado al LLM. El LLM, a su vez, devuelve unaAIMessageque puede contener la respuesta final al usuario o una invocación de una o varias herramientas (tool_calls). - Nodo

call_tool: Cuando el LLM decide usar una herramienta, este nodo se encarga de extraer la invocación de la herramienta (nombre y argumentos) delAIMessage, ejecutar la herramienta especificada y devolver el resultado como unToolMessage. - Definir Aristas y Lógica Condicional:

- Punto de Entrada: El grafo siempre comienza invocando el nodo

call_llmcon el mensaje inicial del usuario. - Desde

call_llm: Se define una arista condicional. Si el LLM decide llamar a una herramienta (indicado por la presencia detool_callsen su salida), la ejecución pasa al nodocall_tool. Si el LLM proporciona una respuesta final y no necesita más herramientas, la ejecución termina (se dirige aEND). - Desde

call_tool: Después de ejecutar una herramienta, la ejecución siempre vuelve al nodocall_llm. Esto permite al agente observar el resultado de la herramienta y decidir, basándose en la nueva información, si necesita realizar otra acción o si ya puede proporcionar una respuesta final. - Compilar y Ejecutar: Una vez definidos los nodos y las aristas, se utiliza

graph.compile()para crear un agente ejecutable y luego se invoca con un mensaje inicial para iniciar el proceso.

Ejemplo de Escenario Simplificado: Agente de Soporte al Cliente

Imagina cómo un agente ReAct de soporte al cliente procesaría una consulta:

- Usuario: «¿Cuál es el estado de mi pedido 12345?»

- LLM (Pensamiento): «El usuario pregunta por el estado de un pedido. Necesito una herramienta para buscar información de pedidos. La herramienta `getOrderStatusTool` parece apropiada.»

- LLM (Acción): Llama a la herramienta

getOrderStatusToolcon el argumentoorder_id="12345". - Observación: La herramienta se ejecuta y devuelve el mensaje «El pedido 12345 está ‘En Tránsito’ actualmente y se espera que llegue en 2 días.»

- LLM (Pensamiento): «He obtenido el estado del pedido. Debo formatear esta información de manera clara y comunicársela al usuario como respuesta final.»

- LLM (Acción): Proporciona la respuesta final al usuario.

- Agente (Salida): «Su pedido 12345 está actualmente En Tránsito y se espera que llegue en 2 días.»

Consideraciones Avanzadas y Próximos Pasos

Una vez que domines los fundamentos, puedes explorar funcionalidades más avanzadas para construir agentes aún más sofisticados:

- Human-in-the-Loop: Integrar puntos en el grafo donde un humano puede revisar, aprobar o modificar las acciones del agente antes de que se ejecuten.

- Manejo de Errores Robustos: Implementar mecanismos de reintento, fallbacks o notificación para gestionar fallos en herramientas o respuestas inesperadas del LLM, haciendo el agente más resiliente.

- Gestión de Memoria Avanzada: Estrategias para manejar historiales de conversación largos y relevantes de manera eficiente, resumiendo o extrayendo información clave para mantener el contexto sin sobrecargar al LLM.

- Sistemas Multi-Agente: Desarrollar arquitecturas complejas donde múltiples agentes ReAct colaboran o compiten para resolver problemas más grandes, con roles y responsabilidades bien definidos.

- Herramientas Personalizadas y Adaptadores: Integrar cualquier API o base de datos externa como una herramienta, o crear adaptadores para sistemas heredados.

- Observabilidad y Monitoreo: Utilizar herramientas como LangSmith para seguir el rastro de la ejecución del grafo, diagnosticar el comportamiento del agente y optimizar su rendimiento.

Primeros Pasos para Principiantes

Para empezar tu viaje en la construcción de agentes ReAct con LangGraph:

- Instala las Librerías Necesarias: Ejecuta

pip install langchain langgraph openai tavily-python(ajusta según los LLMs y herramientas específicas que planees usar). - Configura tus Claves API: Asegúrate de tener configuradas las claves de API necesarias para tu proveedor de LLM (ej. OpenAI, Anthropic) y cualquier herramienta externa (ej. Tavily).

- Comienza de Forma Sencilla: Empieza con un solo agente ReAct, una o dos herramientas y un bucle directo para entender los conceptos básicos antes de añadir complejidad.

- Experimenta: Juega con diferentes prompts, definiciones de herramientas y estructuras de grafo para ver cómo afectan el comportamiento del agente y sus resultados.

- Consulta la Documentación: Las documentaciones oficiales de LangChain y LangGraph son recursos invaluables para profundizar en ejemplos, APIs y mejores prácticas.

Conclusión

La construcción de agentes ReAct representa un avance significativo para hacer que los LLMs sean más confiables, capaces e interactivos, trascendiendo las limitaciones de los modelos básicos. LangGraph proporciona un marco intuitivo y potente para orquestar estos flujos de trabajo complejos y con estado. Al comprender los principios fundamentales de ReAct y aprovechar el enfoque basado en grafos de LangGraph, incluso los principiantes pueden comenzar a desarrollar agentes de IA sofisticados que pueden razonar, actuar y adaptarse de manera inteligente. Esto abre un mundo de posibilidades para la automatización inteligente, la resolución de problemas complejos y la creación de experiencias de usuario más dinámicas. Esta guía sirve como un trampolín fundamental para dominar el arte de construir agentes robustos e inteligentes que cierran la brecha entre los modelos de lenguaje y la interacción significativa con el mundo real.